[et_pb_section admin_label=»section»][et_pb_row admin_label=»row»][et_pb_column type=»4_4″][et_pb_text admin_label=»Texto» background_layout=»light» text_orientation=»left» use_border_color=»off» border_color=»#ffffff» border_style=»solid»]

Una nueva teoría explica cómo funciona el aprendizaje profundo, es decir, en dónde estamos al tratar de reproducir el funcionamiento del cerebro humano en un ordenador

[/et_pb_text][et_pb_image admin_label=»Imagen» src=»http://testnoticias.canal22.org.mx/wp-content/uploads/2017/10/RedneuronalGoogle.jpg» show_in_lightbox=»off» url_new_window=»off» use_overlay=»off» animation=»left» sticky=»off» align=»center» force_fullwidth=»off» always_center_on_mobile=»on» use_border_color=»off» border_color=»#ffffff» border_style=»solid» /][et_pb_text admin_label=»Texto» background_layout=»light» text_orientation=»left» text_font=»Georgia||||» text_font_size=»11″ text_text_color=»#000000″ text_line_height=»1.6em» use_border_color=»off» border_color=»#ffffff» border_style=»solid»]

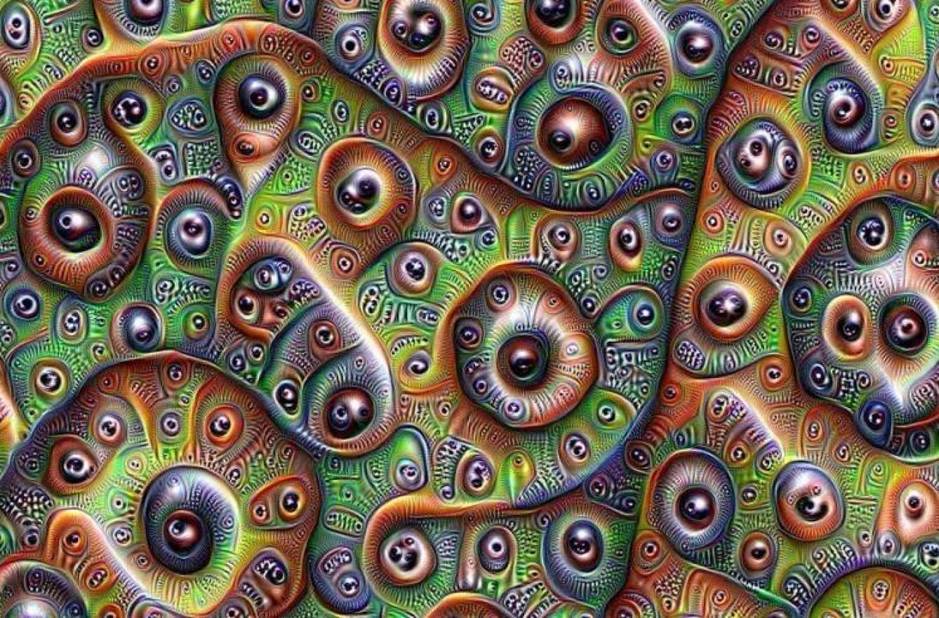

Imagen: Interpretación de la red neuronal de Google Deep Dream

[/et_pb_text][et_pb_text admin_label=»Texto» background_layout=»light» text_orientation=»left» text_font=»Georgia||||» text_font_size=»16″ text_text_color=»#000000″ text_line_height=»1.6em» use_border_color=»off» border_color=»#ffffff» border_style=»solid»]

Ciudad de México (N22/Redacción).- Las redes neuronales profundas han aprendido a conversar, conducir coches, ganar videojuegos, pintar cuadros y ayudar a hacer descubrimientos científicos, así como también han confundido a sus creadores que nunca esperaban lo que se conoce como “ aprendizaje profundo”.

El aprendizaje profundo es un conjunto de algoritmos de aprendizaje automático que intenta traducir abstracciones de alto nivel en datos usando arquitecturas compuestas de transformaciones no lineales múltiples. Ningún principio subyacente ha guiado el diseño de estos sistemas de aprendizaje, aparte de la vaga inspiración extraída de la arquitectura del cerebro. Al igual que un cerebro, una red neuronal profunda tiene capas de neuronas artificiales que son fruto de la memoria de la computadora.

Cuando una neurona se dispara, envía señales a las neuronas conectadas en la capa superior. Durante el aprendizaje profundo, las conexiones en la red se fortalecen o se debilitan según sea necesario para hacer que el sistema mejore al enviar señales de datos de entrada a través de las capas a las neuronas, después de que una profunda red neuronal ha aprendido de miles de muestras y puede identificar a los objetos con la misma precisión que la gente puede hacerlo. El salto mágico de los casos especiales a los conceptos generales durante el aprendizaje da a las redes neuronales profundas su poder.

En una conferencia en Berlín, Naftali Tishby, un informático y neurocientífico de la Universidad Hebrea de Jerusalén, presentó pruebas en apoyo de una nueva teoría que explica cómo funciona el aprendizaje profundo. Tishby argumenta que las redes neuronales profundas aprenden de acuerdo con un procedimiento llamado “cuello de botella de la información”, que él y dos colaboradores describieron por primera vez en términos puramente teóricos en 1999. La idea es que una red libera datos de entrada, que hacen ruido por los detalles extraños, como si estuvieran apretando la información a través de un cuello de botella, conservando sólo las características más relevantes para los conceptos generales. Los sorprendentes nuevos experimentos de Tishby y su estudiante, Ravid Shwartz-Ziv, revelan cómo este proceso de “apretado” ocurre durante el aprendizaje profundo, al menos en los casos que estudiaron, informó el sitio Wired.

“Creo que la idea de cuello de botella de información podría ser muy importante en futuras investigaciones de redes neuronales profundas”, dijo Alex Alemi de Google Research, quien ya ha desarrollado nuevos métodos de aproximación para aplicar un análisis de cuello de botella, “no solo como una herramienta teórica para entender por qué nuestras redes neuronales funcionan tan bien como lo hacen actualmente, sino también como una herramienta para construir nuevos objetivos y arquitecturas de redes”, dijo Alemi.

Algunos investigadores siguen siendo escépticos de que la teoría explique completamente el éxito del aprendizaje profundo, pero Kyle Cranmer, físico de partículas de la Universidad de Nueva York que utiliza el aprendizaje automático para analizar las colisiones de partículas en el Gran colisionador de hadrones, dijo que como principio general de aprendizaje “de alguna manera huele bien”.

[/et_pb_text][/et_pb_column][/et_pb_row][/et_pb_section]