Investigadores de la Universidad de California y Berkeley, han desarrollado una “voz virtual prostética» capaz de generar 150 palabras por minuto

Ciudad de México (N22/Redacción).- A través de la revista Nature, se ha dado a conocer que se ha desarrollado una “voz virtual prostética”, un sistema a través del cual las intenciones de vocalización del cerebro son traducidas en habla inteligible, sin necesidad de mover un sólo músculo.

Tiempo atrás se han desarrollado otros asistentes del habla que funcionan al descifrar las ondas cerebrales, pero no se había conseguido la rapidez ni la fluidez del habla natural. Ahora, este nuevo sistema descifra los comandos de motricidad del cerebro que guían el movimiento vocal cuando hablamos y generan oraciones inteligibles que se aproximan a la cadencia natural de un hablante.

Como se puede leer en una nota publicada por The New York Times, ésta sólo se trata de una prueba de concepto, un vistazo a lo que sería posible con más experimentos y afinaciones; y fue probado com personas que mantienen intacta su calidad del habla, es decir, aún no ha sido probado en aquellos con lesiones neurológicas, que pudieran hacer imposible el descifrado de las ondas cerebrales.

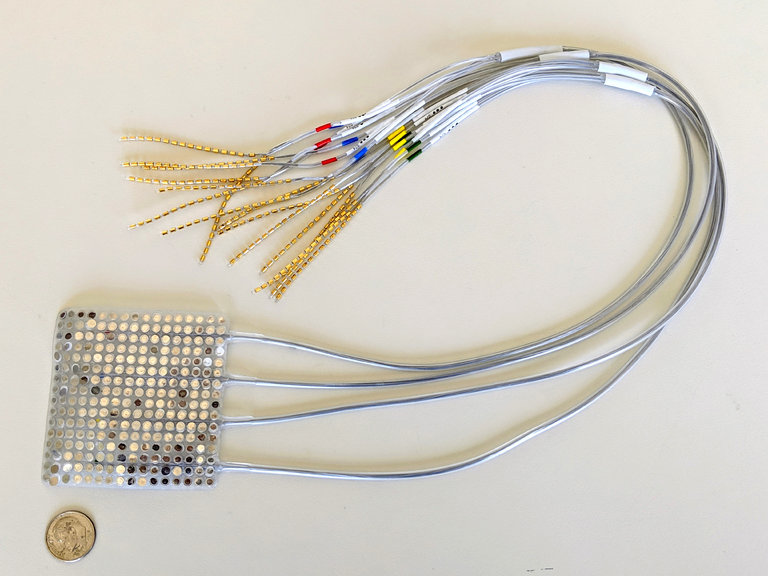

Científicos de la Universidad de California, en San Francisco y de Berkeley, reclutaron a cinco personas que estaban hospitalizadas para evaluación antes de una intervención quirúrgica por epilepsia. Éstos acordaron probar el generador de voz virtual. Cada uno tenía implantados una o dos matrices de electrodos. Mientras los pacientes recitaban cientos de oraciones, los electrodos registraban los patrones de actividad neuronal en la corteza motora cerebral.

Los investigadores asociaron esos patrones con los movimientos sutiles de labios, lengua, laringe y mandíbula que hacían los pacientes al hablar de manera natural. Se tradujeron esos movimientos a las oraciones habladas.

De acuerdo a información publicada por la revista Nature, se reporta que hasta un 70% de lo dicho por la “voz prostética” era comprensible. Este nuevo programa genera alrededor de 150 palabras por minuto, a la par del habla natural.

«Mostramos, al descifrar la actividad cerebral que guía la articulación, que se puede simular un habla más precisa y que suena más natural que la versión sintetizada a partir de la extracción de representaciones del sonido en el cerebro», dijo Edward Chang, profesor de neurocirugía en UCSF y coautor del nuevo estudio. Lo realizó junto con Gopala K. Anumanchipalli, también de UCSF, y Josh Chartier, afiliado tanto a UCSF como al campus en Berkeley.

Fuente: The New York Times / Nature

Imagen: Electrodos ECoG que registran la actividad cerebral de manera intracraneal /USSF